Der Begriff „Entropie“ ist ein fundamentales Konzept in der Physik, hat aber auch weitreichende Implikationen in anderen Wissenschaftsbereichen wie Informationstheorie, Biologie und sogar Sozialwissenschaften. In diesem Modell ist es eines der drei Schlüssel-Phänomene, die eine Dynamik reziproker Resonanzräume bestimmten. Dazu zählen noch die Phänomene Synchronisation und Emergenz, die möglicherweise in einer noch schwer definierbaren Interaktion das Erreichen einer neue Entwicklungsstufe, das Hervorrufen eines Teamgeists oder anderer Entitäten fördern. (Haupthypothese)

Definition:

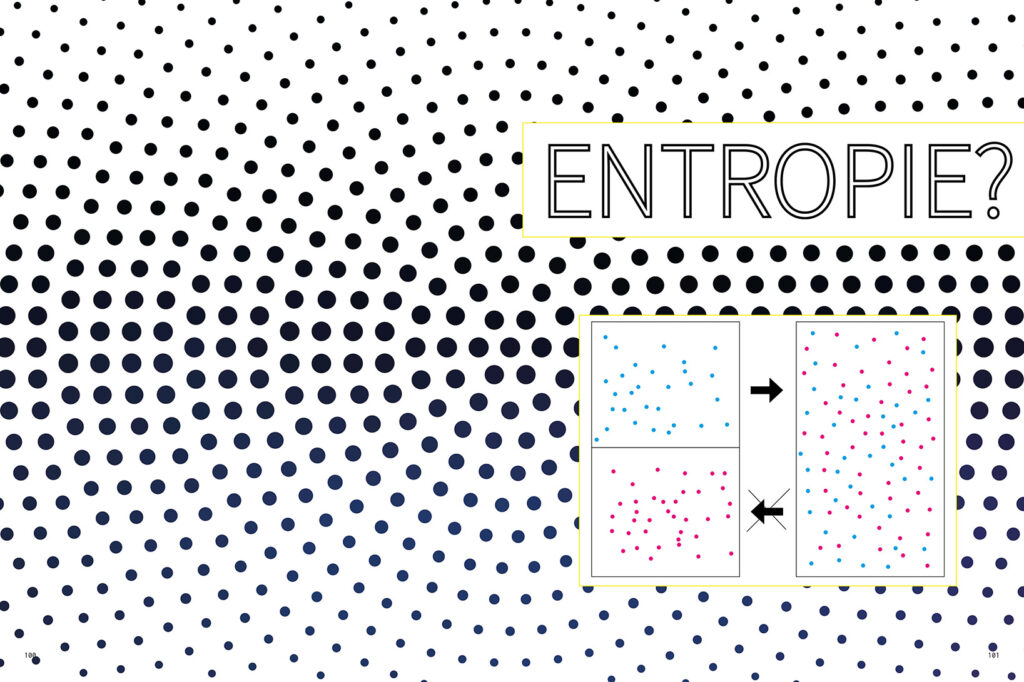

Entropie ist ein Maß für den Grad der Unordnung oder Zufälligkeit in einem System. In der Thermodynamik beschreibt sie die Anzahl möglicher Mikrozustände eines Systems, während sie in der Informationstheorie ein Maß für die Ungewissheit oder den Informationsgehalt darstellt.

Diskussion:

- Thermodynamische Perspektive:

Der Begriff „Entropie“ wurde 1865 von Rudolf Clausius in die Thermodynamik eingeführt [1]. Der zweite Hauptsatz der Thermodynamik besagt, dass die Entropie in einem geschlossenen System nie abnehmen kann. Boltzmann (1877) lieferte eine statistische Interpretation der Entropie, die sie mit der Wahrscheinlichkeit von Mikrozuständen verband [2].

- Informationstheoretische Perspektive:

Shannon (1948) übertrug das Konzept der Entropie in die Informationstheorie, wo sie ein Maß für den Informationsgehalt oder die Ungewissheit in einer Nachricht darstellt [3]. Diese Verbindung zwischen physikalischer und informationstheoretischer Entropie hat tiefgreifende Implikationen für unser Verständnis von Information und Physik.

- Entropie und Ordnung:

Schrödinger (1944) diskutierte in seinem einflussreichen Werk „Was ist Leben?“ die Rolle der Entropie in biologischen Systemen. Er argumentierte, dass Lebewesen „negative Entropie“ aus ihrer Umgebung aufnehmen, um geordnete Strukturen aufrechtzuerhalten [4].

- Entropie in komplexen Systemen:

In der Theorie komplexer Systeme wird Entropie oft im Zusammenhang mit Selbstorganisation und Emergenz diskutiert. Prigogine und Stengers (1984) zeigten, wie Systeme fern vom thermodynamischen Gleichgewicht durch Entropieproduktion geordnete Strukturen erzeugen können [5].

- Entropie und Evolution:

Brooks und Wiley (1988) argumentieren, dass biologische Evolution als entropiegetriebener Prozess verstanden werden kann, bei dem die Zunahme der Entropie mit der Zunahme der biologischen Komplexität einhergeht [6].

- Entropie in der Kognitionswissenschaft:

In der Kognitionswissenschaft wird das Konzept der Entropie zunehmend zur Erklärung kognitiver Prozesse verwendet. Friston (2010) schlug das „Free Energy Principle“ vor, wonach biologische Systeme danach streben, ihre freie Energie (eng verwandt mit Entropie) zu minimieren [7].

- Soziale Entropie:

Bailey (1990) übertrug das Konzept der Entropie auf soziale Systeme und argumentierte, dass soziale Entropie ein Maß für die Ungleichheit und Unordnung in Gesellschaften sein könnte [8].

- Entropie und Zeitpfeil:

Die Zunahme der Entropie wird oft mit der Richtung der Zeit in Verbindung gebracht. Eddington (1928) prägte den Begriff „Zeitpfeil“ und verband ihn mit der Entropiezunahme [9].

- Entropie und Information:

Landauer (1961) zeigte eine fundamentale Verbindung zwischen Information und Physik auf, indem er argumentierte, dass das Löschen von Information immer mit einer Erhöhung der Entropie verbunden ist [10].

- Entropie in der KI-Forschung:

In der KI-Forschung wird Entropie als Maß für die Unsicherheit in Modellen verwendet. Entropie-basierte Methoden spielen eine wichtige Rolle in Bereichen wie maschinellem Lernen und Entscheidungsfindung unter Unsicherheit.

- Entropie und Kreativität:

Einige Forscher haben vorgeschlagen, dass kreative Prozesse als Balance zwischen Ordnung (niedrige Entropie) und Chaos (hohe Entropie) verstanden werden können. Kaufman und Kaufman (2004) diskutieren, wie optimale Levels von Entropie zu kreativen Durchbrüchen führen können [11].

Zusammenfassung:

Entropie ist ein vielseitiges und fundamentales Konzept, das weit über seine ursprüngliche thermodynamische Bedeutung hinausgeht. Es bietet eine Brücke zwischen physikalischen, informationstheoretischen und biologischen Konzepten und hilft uns, Prozesse der Ordnung und Unordnung in verschiedenen Systemen zu verstehen.

In Bezug auf unsere früheren Diskussionen über Resonanzräume und die Entstehung kollektiver Repräsentationen kann Entropie als ein wichtiges Konzept verstanden werden, um die Dynamik von Informationsflüssen und die Entstehung von Ordnung in sozialen und kognitiven Systemen zu beschreiben. Es bietet auch einen konzeptionellen Rahmen für das Verständnis, wie Systeme (seien es biologische, soziale oder künstliche) Information verarbeiten und sich an ihre Umgebung anpassen.

Die Verbindung von Entropie mit Konzepten wie Emergenz und Synchronisation eröffnet neue Perspektiven auf die Entstehung von Komplexität und Ordnung in verschiedenen Systemen, von neuronalen Netzwerken bis hin zu sozialen Strukturen und möglicherweise sogar künstlichen Superintelligenzen.

Literatur:

[1] Clausius, R. (1865). Über verschiedene für die Anwendung bequeme Formen der Hauptgleichungen der mechanischen Wärmetheorie. Annalen der Physik, 201(7), 353-400.

[2] Boltzmann, L. (1877). Über die Beziehung zwischen dem zweiten Hauptsatz der mechanischen Wärmetheorie und der Wahrscheinlichkeitsrechnung respektive den Sätzen über das Wärmegleichgewicht. Wiener Berichte, 76, 373-435.

[3] Shannon, C. E. (1948). A mathematical theory of communication. Bell System Technical Journal, 27(3), 379-423.

[4] Schrödinger, E. (1944). What is life? The physical aspect of the living cell. Cambridge University Press.

[5] Prigogine, I., & Stengers, I. (1984). Order out of chaos: Man’s new dialogue with nature. Bantam Books.

[6] Brooks, D. R., & Wiley, E. O. (1988). Evolution as entropy. University of Chicago Press.

[7] Friston, K. (2010). The free-energy principle: a unified brain theory? Nature Reviews Neuroscience, 11(2), 127-138.

[8] Bailey, K. D. (1990). Social entropy theory. State University of New York Press.

[9] Eddington, A. S. (1928). The nature of the physical world. Cambridge University Press.

[10] Landauer, R. (1961). Irreversibility and heat generation in the computing process. IBM Journal of Research and Development, 5(3), 183-191.

[11] Kaufman, J. C., & Kaufman, A. B. (2004). Applying a creativity framework to animal cognition. New Ideas in Psychology, 22(2), 143-155.